Jak często boty Google odwiedzają Twoją stronę? Od czego to zależy? Ekspert z Google odpowiada

Crawlerem nazywamy program, który porusza się po sieci, skanując poszczególne witryny, a jego zadaniem jest indeksacja stron internetowych, czyli rejestrowanie wszelkich aktualizacji. Pozytywne zmiany i wzbogacanie treści na naszych stronach dobrze wpływa na pozycjonowanie, zatem wizyty Googlebota, który je zaindeksuje, są zazwyczaj przez nas mile widziane. Co jednak decyduje o częstotliwości odwiedzin crawlerów? Ciekawych informacji dowiadujemy się na ten temat od Johna Muellera, eksperta pracującego dla Google jako Senior Webmaster Trends Analyst.

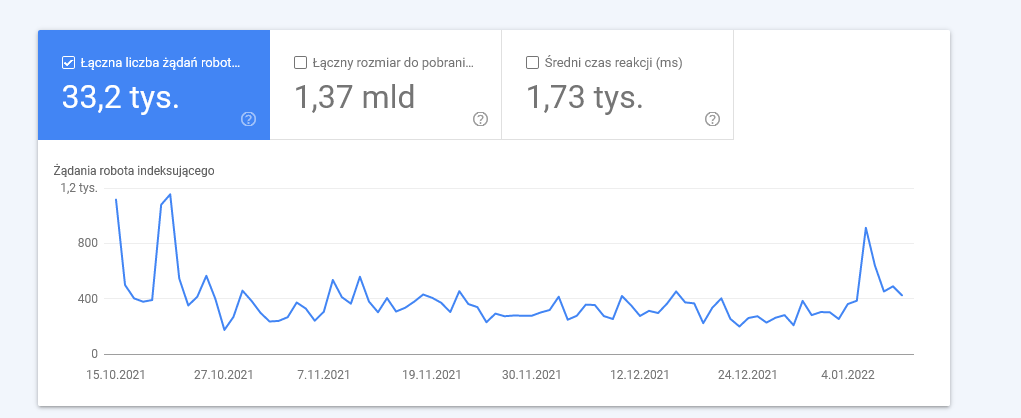

Jak często crawlery odwiedzają Twoją stronę, można sprawdzić w Google Search Console

Pytanie do eksperta Google – jak działają te crawlery?

Ekipa Google doskonale zdaje sobie sprawę z tego, że działanie najpopularniejszej wyszukiwarki nigdy nie będzie do końca jasne dla wszystkich, zwłaszcza biorąc pod uwagę, częste zmiany algorytmów. Dlatego właśnie powstała inicjatywa tzw. sesji w godzinach pracy, czyli konferencji na żywo, podczas których eksperci odpowiadają na pytania. Z wątpliwościami zgłaszają się zarówno przedsiębiorcy, prowadzący własne strony, jak i specjaliści do spraw SEO, którzy chcą zasięgnąć opinii ze źródła. Podczas sesji z dnia 7 stycznia 2022, zostało poruszone zagadnienie crawlerów.

Pytający przytoczył przykład swojej strony z newsami, na której dawniej codziennie publikował artykuły. Zaobserwował wówczas, że crawlery skanowały jego witrynę niemal każdego dnia w poszukiwaniu nowego kontentu. Jednak po pewnym czasie, kiedy dodawanie kolejnych treści stało się mniej regularne, częstotliwość odwiedzin bota indeksującego spadła. John Mueller został poproszony o komentarz w tej sprawie.

Dwa rodzaje crawlerów

Bardzo ciekawą informacją, jaka wynikła z wypowiedzi Johna Muellera, jest fakt istnienia dwóch typów crawlerów. Boty, które zajmują się tzw. discovery crawl, czyli indeksowaniem nowych podstron w obrębie danej domeny to jeden rodzaj. Drugi typ to refresh crawl, polegający na odkrywaniu nowych treści dodanych do zaindeksowanej już wcześniej podstrony. Ekspert przyznał, że na ogół witryny są przez boty typu refresh crawl, do momentu aż zostaną odkryte nowe linki, a wtedy strona skanowana jest ponownie przez drugi rodzaj crawlera.

Twoja regularność ma znaczenie

Co jednak z najważniejszą kwestią, czyli wpływem regularnych publikacji na częstotliwość pojawiania się u nas botów indeksujących? Według Muellera gra ona dużą rolę. Googlebot uczy się, w jakich odstępach czasu powinien skanować naszą stronę, właśnie na podstawie tego, jak często pojawiają się na niej nowe strony. Słowami eksperta:

„ Jeśli na przykład posiadasz stronę z newsami, którą aktualizujesz co godzinę, nauczymy się, że należy ją co godzinę skanować. Natomiast jeżeli strona z newsami publikuje raz w miesiącu, wnioskujemy, że nie trzeba skanować tak często. I nie jest to kwestia jakości czy pozycji ani niczego w tym stylu. Po prostu nauczyliśmy się, że z technicznego punktu widzenia, możemy skanować ją raz dziennie czy tygodniowo i to jest w porządku.”

Komentarze 1

Bardzo ciekawa informacja